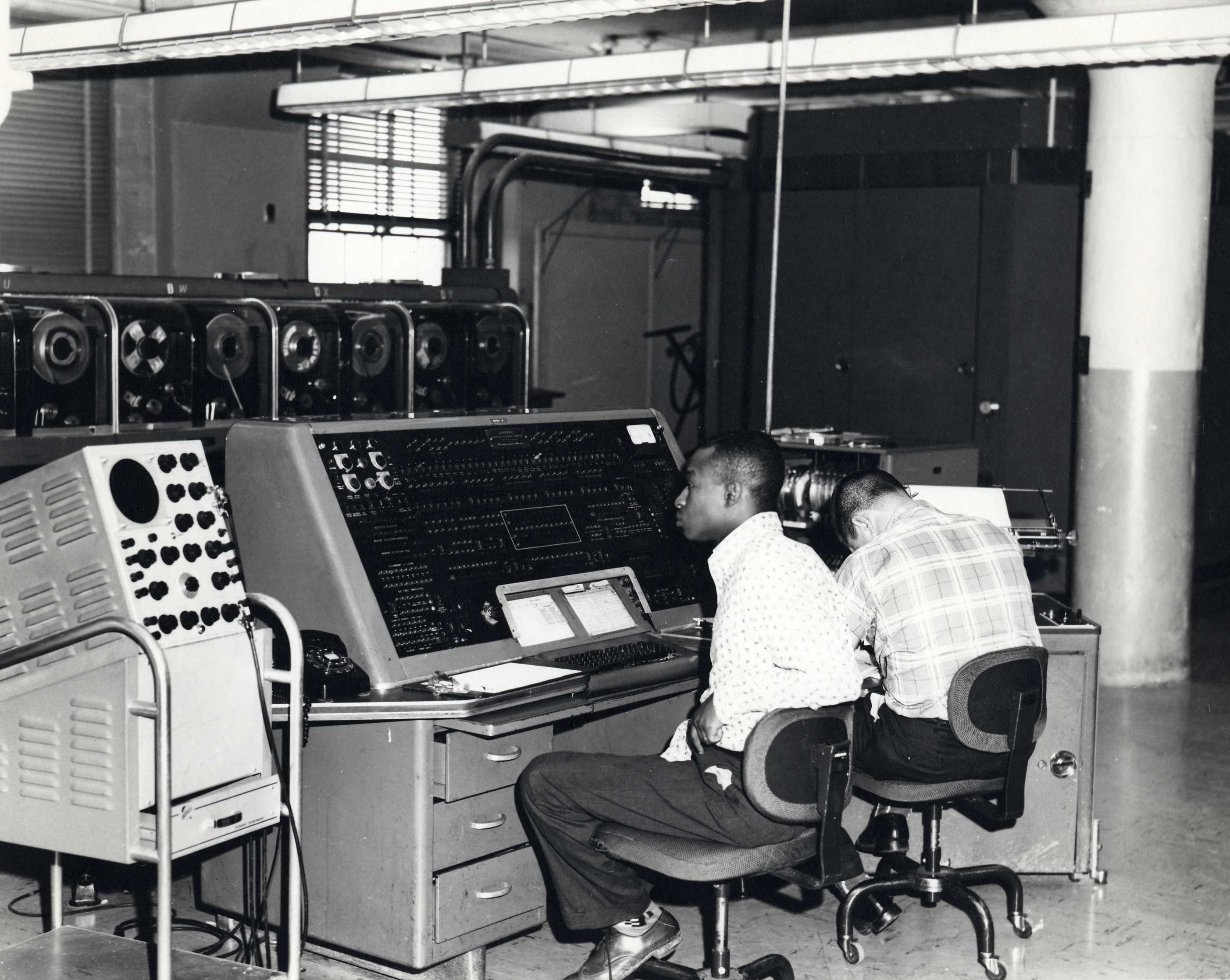

Er ist eine Art Fabrikanlage (S.12) – ganz im Sinne der Zeit (S.12) – er wird gefüttert und anschliessend wird gerechnet (eigene Box mit Elektroröhren) und gespeichert (eigene Box Lochkarten, Magnetbändern) oder gedruckt (eigene Hardware wie Printer). Dabei ist die Frage, was ein Computer ist noch weit offen, denn so wird vermutet: Turing oder Neumann haben wohl die wenigsten gelesen (S. 18). Die Anlage soll all das schneller machen, so etwa Wahlauszählungen oder Volkszählungen (in den USA alle 10 Jahre).

Grundfunktionen: Sortieren, klassifizieren, rechnen, entscheiden

Die Grundfunktionen sind dabei sortieren, klassifizieren, rechnen entscheiden und das alles gleichzeitig im Gegensatz zu den Hollerith-Maschinen – etwa bei Auszählungen.

Simulation des UNIVAC Computers online >

Anwendungsfelder

Der Autor geht dabei der Frage nach: Wie wird überhaupt gerechnet zu dieser Zeit. Er breitet das Feld verschiedener (S. 23) Arten des Rechnens aus. Bräuchte jeder einen Rechner? Viele Tätigkeiten werden geschätzt (etwa Bedarf, Gewohnheit), oft werden vorberechnete Tabellen benutzt (siehe Formelbuch) und oft wird auch etwa im Versicherungsgeschäft vor Ort gerechnet und anschliessend erst nachgerechnet und systematisiert oder Tagesabschlüsse werden erst in der Zentrale detailiert berechnet. Der Autor nennt diese Art des Nicht-Echtzeitrechnens auch die Temporalisierung des Rechnens.

Der UNIVAC geht auf jeden Fall einen Schritt näher und ermöglicht zumindest im Backoffice (für den Preis) neue Arten von Anwendungen.

Das Buch thematisiert dabei, dass selbst zu diesem Zeitpunkt, die alte (elektromechanische) Technik nicht etwa überholt wurde, sondern zeitweise nebeneinander bestanden und einander unterstützte. Klar wird dabei auch, warum es im Französischen bis heute ein ‚ordinateur‘ (S. 36) heisst.

Programmierung – Stau vor dem Rechner

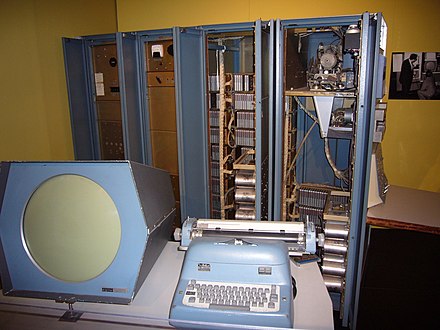

Ein Rechner wie etwa der Z4 (Zuse) der ETH (ERMETH ab 1953 eingeführt durch Eduard Stiefel, steht heute im Kommunikationsmuseum in Bern) benötigte neben viel Geld für Anschaffung (Bau) und Unterhalt, Personal (S. 39).

Das Personal bereitete die Befehle vor und danach rechnete der Computer diese durch – eine „reproduktive Maschine“ (S. 39). Der Flaschenhals war mehrheitlich die Schlange vor dem Rechner ausgelöst auch etwa durch ‚Programmierfehler‘. Nach und nach entstanden Lösungen für diese Probleme: Programme konnten bei einem Fehler gestoppt und weitergeführt werden oder wurden compiliert (also darauf untersucht, ob sie überhaupt lauffähig waren).

„Die Disziplinierung und Disziplin der Programmierer war die wichtigste Voraussetzung für den Gehorsam der Rechner. Und umgekehrt.“ (S46)

Aber auch inhaltlich musste das Ganze vermittelt werden:

„Es galt den ohnehin prekären akademischen Ruf dieser Disziplin nicht unnötig aufs Spiel setzen. Darum versuchte Stiefel, das Programmieren von den ETH-Mathematikern fernzuhalten und wie eine heisse Kartoffel an seine Auftraggeber in der Industrie weiterzureichen“ (S. 41)

Denn schliesslich bestand das Gerät „aus einem amorphen Haufen von Elektronenröhren oder anderen Schaltelemente, in welchem sogar die Addition einstelliger Zahlen programmiert werden musste.“ (S44)!

„Datenverarbeitung setzte also Datenverarbeitung“ (S. 52) voraus

Nicht zu vergessen ist dabei auch, dass die Daten bevor sie verarbeitet wurden, in ein Format bzw. auf Lochkarten oder Magnetbänder ’normalisiert‘ werden mussten.

Emanzipation von der Lochkartenstapelverarbeitung – Random Access

Im Grunde aber nutzten die meisten Firmen diese ‚Computer‘ zur Verarbeitung von Stappeln.

„Was Firmen auf digitalen, programmierbaren Rechenanlagen taten, sei nichts anderes als eine ‚file-maintenance operation'“. (S. 63)

Eine Emanzipation von der Technikkultur hin zu mehr Möglichkeiten fand erst statt, als die Daten nicht mehr nach ihrer Nutzung organisiert, gespeichert und geladen wurden (S. 63+) sondern frei zugänglich waren. Dieses System nannte sich dann auch Random Access (Memory) noch heute RAM genannt.

Organisation des Computers – Time Sharing

Ebenfalls geteilt sollte sehr bald auch die Rechenzeit, damit die Ressourcen des Rechnens besser genutzt werden konnten:

„Während also der eine Programmierer über seinen Fehlern brütete oder sich neue (fehlerhafte) Instruktionen ausdachte, konnte man den Rechner gut und gerne einem anderen Nutzer überlassen.“ (S. 67)

Die Lösung kennen wir heute, damals klang das folgendermassen in Anlehnung an eine Telefonzentrale:

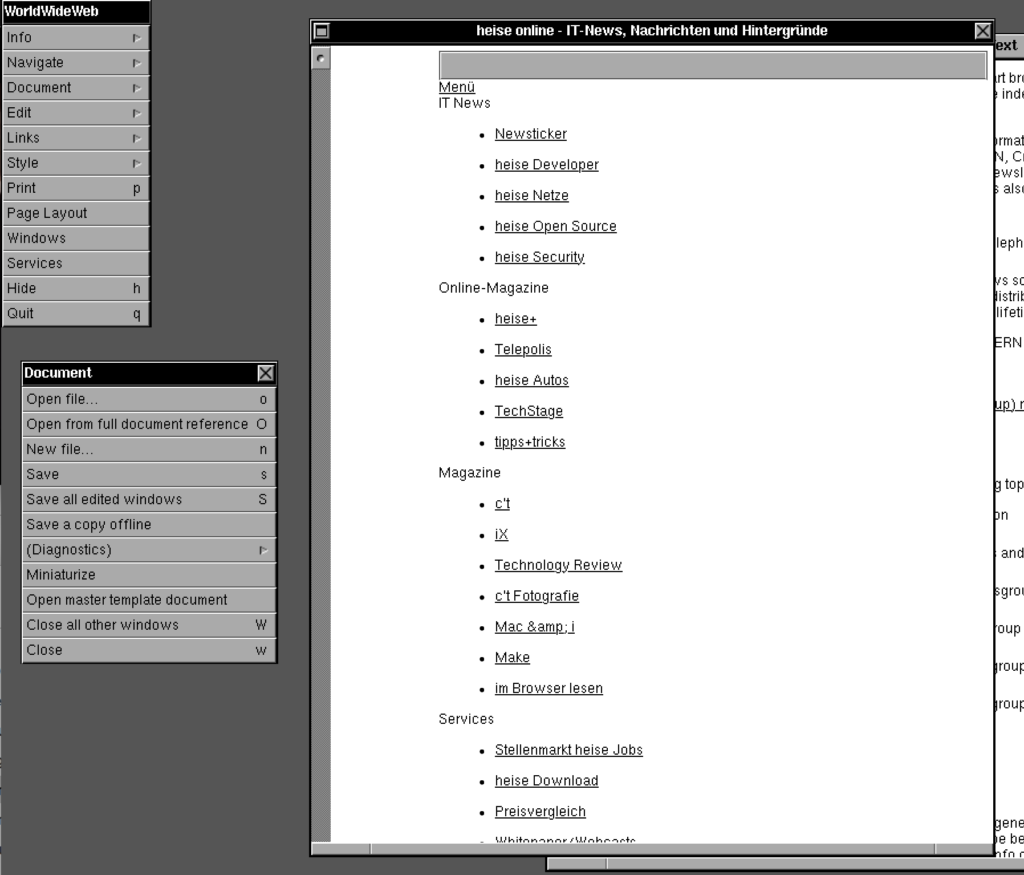

„Jeder Nutzer sollte einen eigenen Apparat, eine eigene Konsole bedienen können sich nicht um die Aktivität anderer User kümmern müssen. Für letzteres war allein die Zentrale zuständig.“ (S. 71)

Betriebssystem als Dispositiv

Die Lösung dieses Problems war eine grundlegende Software – Super Visor, Control System oder letztlich Betriebssystem genannt:

Diese wägte Nutzungsansprüche, Zugriffsrechte, Ausbeutungsformen und Rechenschaftspflichten gegeinander ab und regelte das systemkonforme Zusammenspiel von Hardwarekomponenten, Daten, Anwendungsprogrammen, peripheren Apparturen und Nutzern. (S. 75)

Diese Polizei (S. 77) kontrollierte den Rahmen oder anders gesagt, war das Regelsystem des Systems oder Dispositiv (S. 78) Die Kosten der Entwicklung und damit auch des Betriebes dafür sind immens: „Rund 5000 Mannjahre soll die Entwicklung von OS/360 bei IBM gekostet haben.“ (S. 79)

Organisationen von Firmen entlang von Grossrechnern

In „Automation der öffentlichen Verwaltung“ bezeichnete Niklas Luhmann die „hohen Investitionskosten der 1960er Jahre als Hauptgrund dafür, dass der Rechner Bürokratien eine derartige konzeptionelle organisatorische Herausforderung darstellte.“ (S. 81) Dies führe zu einem ‚Denkzwang‘ meinte Luhmann.

„‚Ihr Preis zwingt dazu, die Organisation der Datenverarbeitung auch ausserhalb der eigentlichen Anlage in einem Masse zu rationalisieren, das ohne diesen Anstoss undurchführbar geblieben wäre.‘ Es galt also viel und gründlicher nachzudenken, um Verwaltung als System zu verstehen und danach jene Abläufe, die in Verwaltungen selbstverständlich sind, in ein computerkompatibles Format zu übersetzen.“ (S. 81+)

Der Autor geht dabei sogar weiter und bezieht die Theorie von Luhmann direkt auf Computerprogramme:

„Dennoch besteht kein Zweifel daran, dass sich Luhmann und Simon vom abstrakten Regelspiel inspirieren liessen, das Rechner für ihren etrieb benötigen, und ebenso von Konzepten und Prozeduren, die im Bereich der Organisation von Rechnern Verwendung fanden. Dies zeigt sich etwa in dem programm bzw. der Überzeugn, dass Organisationen und soziale System der unterschiedlichensten art (wie Rechner) abstrakten Prinzipien der Strukturbildung folgten und dass sich dewsegen auch allgemeine Prinzipien von Organisation bestimmen liessen.“ (S. 83)

Kleinste Informatikprojekte führen deswegen zwangsläufig zu Umstrukturierungen, so der Autor.

IBM gegen den Rest – DEC und Konsorten

IBM hatte immer auf die Hardware und Produktlinien gesetzt. Nun stiegen neuere Anbieter mit kleineren Rechnern ein wie DEC mit der PDP 1960+ und lieferten Kopien. 1969 trug IBM diesem Umstand Rechnung und gab bekannt nun Soft- und Hardware als eigenständige Sparten zu betreiben.

Damit begannen auch die Auseinandersetzungen um Programmiersprachen und Standards etwa bei Algol aktueller zu werden (vgl. Niklaus Wirth – S.115).

Vernetzt (S. 142+)

Um den Austausch von Daten sowohl mit eigenen wie auch mit fremden Computersystemen (und Architekturen) zu ermöglichen, entstanden verschiedene Kommunicationsstandards, die jeweils nicht kompatibel zueinander waren. Das Rennen machte am Schluss aber das TCP/IP-Protokoll von DARPA gegen alle Erwartungen. Anders als andere Ansätze setzten hier verschiedene Protokolle aufeinander auf und neutralisierten damit die darunterliegende Hardware.

(Kommentar: Prinzipiell wurde hier alles entwickelt, was danach im Home- und Personalcomputerbereich nochmals implementiert wurde.)

Homebrew Personal Computer oder Altair 8800

1975 kam der Altair 8800 als Baukasten auf den Markt. Der Entwickler oder die Entwicklerin hatte hier vom Zusammenlöten bis zum Programmieren alles selbst in der Hand. Wobei vorerst unklar war, wofür man diesen Computer wirklich benutzen konnte. Dieser Computer musste zuerst noch seine Möglichkeiten finden und dies im Heimbereich.

Eine Bewertung von Jim Warren kam zum Schluss, dass herkömmliche Geschäfts- und Industrieanwendungen nicht in Frage kommen. Eventuell seien mögliche Anwendungen Spiele, Gruppenspiele und „Spiele hätten ja auch einen erzieherischen Wert“ (S.163). „Zudem könnten Musik- und Radioanwendungen an BBedeutung zunehmen. Unter Umständen gebe es ein gewisses Interesse an Textverarbeitung. Aber ohne guten Drucker … “ (S.163)

Atari 2600

(Bemerkung: Dies trifft die Sache eigentlich recht gut, denn das 1977 auf den Markt kommende Atari 2600 (VCS) war ebenfalls ein System mit einem 6507 Prozessor (der Kopie des 6800), verfügt über 192 Bytes statt 255 Bytes (kein Videoram).

In den folgenden Jahren entwickelte sich die Personal Computer Branche aber rasant und mit den Heimcomputern setzte sich auch die Demokratisierung zu Hause durch. Stimmen meinen auch, dass der Videogame-Crash (auch Atari Shock) diesem Umstand zu verdanken ist.

Das Rhizom – Hypertext, Hypercard, Html

Abschliessend geht der Autor darauf ein, dass zunehmend versucht wurde, Daten unabhängig von ihrer Nutzung (Procedural, S.172+) zu speichern und mit günstig verfügbarem Speicher wurden relationale Datenbankmodelle Ende der 70er Jahre ‚feasible‘. Weiterhin bestand aber die Frage, ob diese Datenbankmodelle überhaupt der letztlich richtige Ansatz war für alle möglichen Daten. Oder mussten Daten nicht grundsätzlich anders verteilt und gespeichert werden? Angefangen mit Ted Nelsons Xanadu (60er Jahre) über Hypercard von Apple (1987+) bis letztlich hin zu Tim Berners Lee HTML (1990) mit verteilten Ressourcen. (Kommentar: Wobei für Tim Berners Lee das WWW immer auch ein beschreibbares Netz war. Mehr dazu findet man hier).

In diesem Blogbeitrag wurden nur die wichtigsten Aspekte des Buches aufgegriffen. Es gibt daneben noch einige Fallbeispiele (NASA, Kriminalbekämpfung, Bankensoftware), die klarer machen, wie sehr die Geschichte offen war.

Dabei sollte nicht vergessen werden, dass jeder Wandel auch genutzt wird, um Interessen durchzusetzen:

„Technologien sind Instrumente, die von sozialen Akteuren (Nutzergruppen, Organisationen) eingesetzt werden, um eigene Interessen zu stärken, bestehende Positionen zu festigen oder zusätzlich Einfluss auf den Gang der Dinge zu gewinnen.“ (S. 84)